The Database Abstraction Layer (DAL)

DAL introduction

py4web rely on a database abstraction layer (DAL), an API that maps Python objects into database objects such as queries, tables, and records. The DAL dynamically generates the SQL in real time using the specified dialect for the database back end, so that you do not have to write SQL code or learn different SQL dialects (the term SQL is used generically), and the application will be portable among different types of databases. The DAL choosen is a pure Python one called pyDAL. It was conceived in the web2py project but it’s a standard python module: you can use it in any Python context.

Nota

What makes pyDAL different from most of the other DALs is the syntax: it maps records to python dictionaries, which is simpler and closer to SQL. Other famous frameworks instead strictly rely on an Object Relational Mapping (ORM) like the Django ORM or the SQL Alchemy ORM, that maps tables to Python classes and rows to Objects.

A little taste of pyDAL features:

Transactions

Aggregates

Inner & Outer Joins

Nested Selects

Nota

An important difference between py4web and web2py is that only some few Field attributes are safe to modify in actions. See Thread safety and Field attributes for more info, and De web2py para py4web for a general list of differences.

Supported databases

A partial list of supported databases is show in the table below. Please check on the py4web/pyDAL web site and mailing list for more recent adapters.

Nota

In any modern python distribution SQLite is actually built-in as a Python library. The SQLite driver (sqlite3) is also included: you don’t need to install it. Hence this is the most popular database for testing and development.

The Windows and the Mac binary distribution work out of the box with SQLite and PostgreSQL only. To use any other database back end, run a full py4web distribution and install the appropriate driver for the required back end. Once the proper driver is installed, start py4web and it will automatically find the driver.

Here is a list of the drivers py4web can use:

Database |

Drivers (source) |

|---|---|

SQLite |

sqlite3 ou pySqlite2 ou zxJDBC (em Jython) |

PostgreSQL |

psycopg2 ou zxJDBC (em Jython) |

MySQL |

pymysql ou MySQLdb |

Oráculo |

cx_Oracle |

MSSQL |

pyodbc ou pypyodbc |

FireBird |

KInterbasDB ou FDB ou pyodbc |

DB2 |

pyodbc |

Informix |

informixdb |

Ingres |

ingresdbi |

CUBRID |

cubriddb |

Sybase |

Sybase |

Teradata |

pyodbc |

SAPDB |

sapdb |

MongoDB |

pymongo |

IMAP |

imaplib |

Support of MongoDB is experimental. Google NoSQL is treated as a particular case. The Gotchas section at the end of this chapter has some more information about specific databases.

The DAL: a quick tour

define py4web as seguintes classes que compõem o DAL:

- DAL

represents a database connection. For example:

db = DAL('sqlite://storage.sqlite')

- Table

represents a database table. You do not directly instantiate Table; instead,

DAL.define_tabledoes.db.define_table('mytable', Field('myfield'))

Os métodos mais importantes de uma tabela são:

`` Insert``, `` truncate``, `` drop``, e `` import_from_csv_file``.

- Field

represents a database field. It can be instantiated and passed as an argument to

DAL.define_table.- Rows

is the object returned by a database select. It can be thought of as a list of

Rowrows:rows = db(db.mytable.myfield != None).select()

- Row

contains field values:

for row in rows: print(row.myfield)

- Query

is an object that represents a SQL “where” clause:

myquery = (db.mytable.myfield != None) | (db.mytable.myfield > 'A')

- Set

is an object that represents a set of records. Its most important methods are

count,select,update, anddelete. For example:myset = db(myquery) rows = myset.select() myset.update(myfield='somevalue') myset.delete()

- Expression

is something like an

orderbyorgroupbyexpression. The Field class is derived from the Expression. Here is an example.myorder = db.mytable.myfield.upper() | db.mytable.id db().select(db.table.ALL, orderby=myorder)

Usando o DAL “stand-alone”

pyDAL is an independent python package. As such, it can be used

without the web2py/py4web environment; you just need to install

it with pip. Then import the pydal module when needed:

>>> from pydal import DAL, Field

Nota

Even if you can import modules directly from pydal, this is not

advisable from within py4web applications. Remember that py4web.DAL

is a fixture, pydal.DAL is not. In this context, the last command

should better be:

>>> from py4web import DAL, Field

Experimentar com o shell py4web

You can also experiment with the pyDAL API using the py4web shell, that is available using the Opção `` comando shell``.

Aviso

Mind that database changes may be persistent. So be careful and do NOT hesitate to create a new application for doing testing instead of tampering with an existing one. The only exception is the showcase db: in case of problems you can recreate it by simply deleting the database folder and restarting py4web. This will re-create the database with all the example data.

Note that most of the code snippets that contain the python prompt

>>> are also directly executable via a py4web shell.

This is a simple example, using the provided showcase app:

>>> from apps.showcase.examples.models import db

>>> db.tables()

['auth_user', 'auth_user_tag_groups', 'person', 'superhero', 'superpower', 'tag', 'thing', 'user_token', 'dummy']

>>> rows = db(db.superhero.name != None).select()

>>> rows.first()

<Row {'id': 1, 'tag': <Set ("tag"."superhero" = 1)>, 'name': 'Superman', 'real_identity': 1}>

You can also start by creating a connection from zero. For the sake of simplicity, you can use SQLite. Nothing in this discussion changes when you switch the back-end engine.

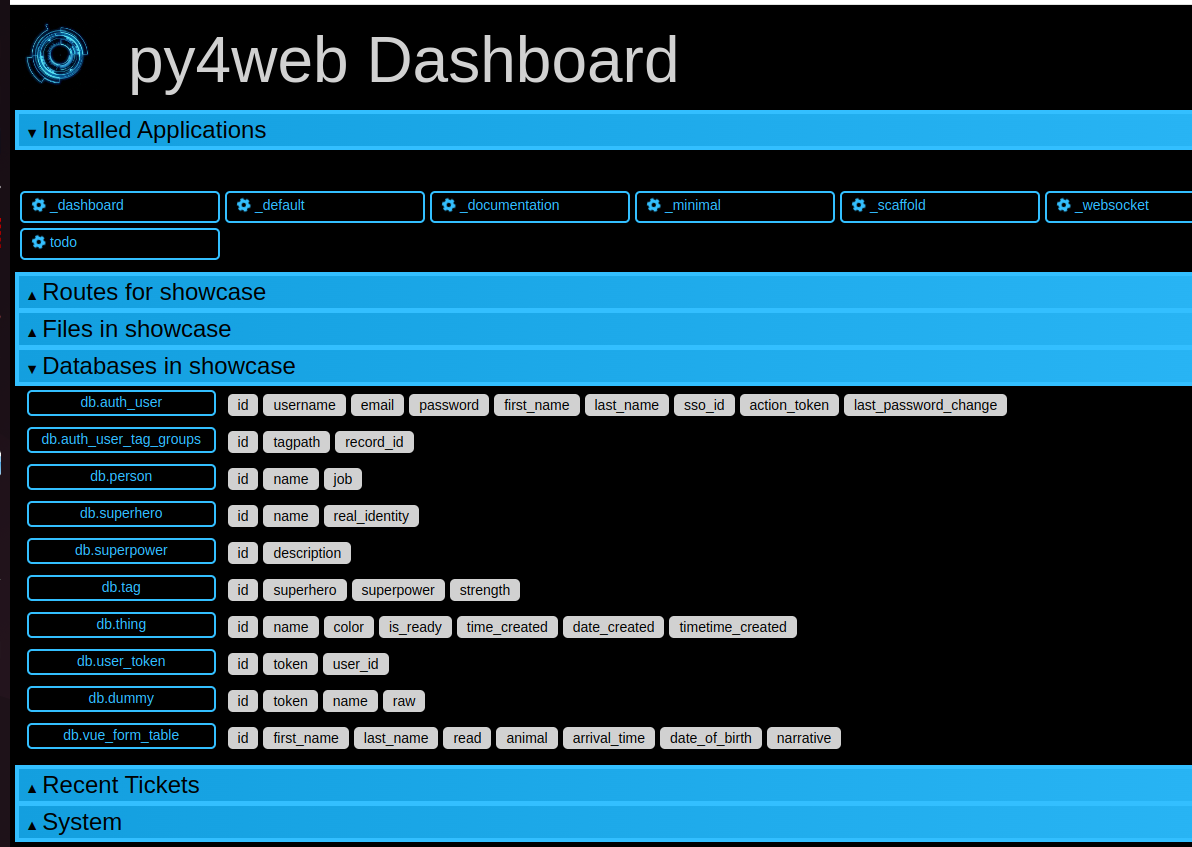

Using the dashboard app with databases

Generally you can use the dashboard app for viewing and modifying the databases of a particular app. However this is not bulletproof, so for security reason this by default is not applied to the showcase app. But if your installation is local (not exposed to public networks), you can enable it by simply adding to the file``apps/showcase/__init__.py`` the line:

from .examples.models import db

This allow you to look graphically inside the showcase application database:

Construtor DAL

Uso básico:

>>> db = DAL('sqlite://storage.sqlite')

O banco de dados agora está conectado e a conexão é armazenado na variável global `` db``.

A qualquer momento você pode recuperar a string de conexão.

>>> db._uri

sqlite://storage.sqlite

e o nome do banco

>>> db._dbname

sqlite

The connection string is called _uri because it is an instance of

a uniform resource identifier.

A DAL permite várias ligações com o mesmo banco de dados ou com diferentes bases de dados, mesmo bases de dados de diferentes tipos. Por enquanto, vamos supor a presença de um único banco de dados uma vez que esta é a situação mais comum.

Assinatura da DAL

DAL(uri='sqlite://dummy.db',

pool_size=0,

folder=None,

db_codec='UTF-8',

check_reserved=None,

migrate=True,

fake_migrate=False,

migrate_enabled=True,

fake_migrate_all=False,

decode_credentials=False,

driver_args=None,

adapter_args=None,

attempts=5,

auto_import=False,

bigint_id=False,

debug=False,

lazy_tables=False,

db_uid=None,

do_connect=True,

after_connection=None,

tables=None,

ignore_field_case=True,

entity_quoting=False,

table_hash=None)

Strings de conexão (o parâmetro uri)

Uma ligação com o banco de dados é estabelecida através da criação de uma instância do objecto DAL:

db = DAL('sqlite://storage.sqlite')

`` Db`` não é uma palavra-chave; é uma variável local que armazena o objeto de conexão `` DAL``. Você é livre para dar-lhe um nome diferente. O construtor de `` DAL`` requer um único argumento, a string de conexão. A seqüência de conexão é o único código py4web que depende de um banco de dados específico back-end. Aqui estão alguns exemplos de strings de conexão para tipos específicos de bancos de dados de back-end suportados (em todos os cases, assumimos o banco de dados está sendo executado a partir de localhost na sua porta padrão e é chamado de “teste”):

Database |

Connection string |

|---|---|

** ** SQLite |

`` SQLite: // storage.sqlite`` |

** ** MySQL |

|

** ** PostgreSQL |

|

** MSSQL (legado) ** |

`` Mssql: // username: password @ localhost / test`` |

** MSSQL (> = 2005) ** |

|

** MSSQL (> = 2012) ** |

|

** ** FireBird |

|

Oráculo |

`` Oracle: // username / password @ test`` |

** ** DB2 |

`` Db2: // username: password @ test`` |

** ** Ingres |

|

** ** Sybase |

|

** ** Informix |

`` Informix: // username: password @ test`` |

** ** Teradata |

|

** ** CUBRID |

|

** ** SAPDB |

`` Sapdb: // username: password @ localhost / test`` |

** ** IMAP |

`` Imap: // utilizador: senha @ servidor: port`` |

** ** MongoDB |

|

** Google / SQL ** |

`` Google: sql: // projecto: instance / database`` |

** Google / NoSQL ** |

`` Google: datastore`` |

** Google / NoSQL / NDB ** |

`` Google: armazenamento de dados + ndb`` |

in SQLite the database consists of a single file. If it does not exist, it is created. This file is locked every time it is accessed. In addition to the file “storage.sqlite” that contains the data, there will be also a sql.log file plus one additional file called longhash_tablename.table for every table definition. The table definition files are used during migrations; in case of problems they could be deleted (they’ll be automatically recreated).

in the case of MySQL, PostgreSQL, MSSQL, FireBird, Oracle, DB2, Ingres and Informix the database “test” must be created outside py4web. Once the connection is established, py4web will create, alter, and drop tables appropriately.

in the MySQL connection string, the

?set_encoding=utf8mb4at the end sets the encoding to UTF-8 and avoids anInvalid utf8 character string:error on Unicode characters that consist of four bytes, as by default, MySQL can only handle Unicode characters that consist of one to three bytes.in the Google/NoSQL case the

+ndboption turns on NDB. NDB uses a Memcache buffer to read data that is accessed often. This is completely automatic and done at the datastore level, not at the py4web level.it is also possible to set the connection string to

None. In this case DAL will not connect to any back-end database, but the API can still be accessed for testing.

Some times you may also need to generate SQL as if you had a connection but without actually connecting to the database. This can be done with

db = DAL('...', do_connect=False)

In this case you will be able to call _select, _insert,

_update, and _delete to generate SQL but not call select,

insert, update, and delete; see Generating raw SQL

for details. In most of the cases you can use

do_connect=False even without having the required database drivers.

Observe que, por padrão py4web usos utf8 codificação de caracteres para bancos de dados. Se você trabalha com bancos de dados que se comportam de forma diferente existente, você tem que mudá-lo com o parâmetro opcional `` db_codec`` como

db = DAL('...', db_codec='latin1')

Caso contrário, você vai ter bilhetes UnicodeDecodeError.

O pool de conexões

Um argumento comum do construtor DAL é a `` pool_size``; o padrão é zero.

As it is rather slow to establish a new database connection for each request, py4web implements a mechanism for connection pooling. Once a connection is established and the page has been served and the transaction completed, the connection is not closed but goes into a pool. When the next request arrives, py4web tries to recycle a connection from the pool and use that for the new transaction. If there are no available connections in the pool, a new connection is established.

Quando py4web começa, a piscina é sempre vazio. A piscina cresce até o mínimo entre o valor de `` pool_size`` e o número máximo de solicitações simultâneas. Isto significa que se `` POOL_SIZE = 10`` mas o nosso servidor nunca recebe mais de 5 solicitações simultâneas, em seguida, o tamanho real piscina só vai crescer a 5. Se `` POOL_SIZE = 0`` então o pool de conexão não é usada.

Conexões nas piscinas são compartilhados sequencialmente entre threads, no sentido de que eles podem ser usados por dois tópicos diferentes, mas não simultâneas. Há apenas uma piscina para cada processo py4web.

O parâmetro `` pool_size`` é ignorado pelo SQLite e Google App Engine. pool de conexão é ignorado para SQLite, uma vez que não daria qualquer benefício.

Falhas de conexão (parâmetro tentativas)

Se py4web não consegue se conectar ao banco de dados que espera 1 segundo e por tentativas padrão novamente até 5 vezes antes de declarar um fracasso. No case do pool de conexão, é possível que uma conexão em pool que permanece aberta, mas sem uso por algum tempo está fechado até o final de banco de dados. Graças à py4web recurso repetição tenta restabelecer essas ligações interrompidas. O número de tentativas é definido através do parâmetro tentativas.

Tabelas preguiçosos

Setting lazy_tables = True provides a major performance boost (but

not with py4web). It means that table creation is deferred until the

table is actually referenced.

Aviso

You should never use lazy tables in py4web. There is no advantage, no need, and possibly concurrency problems.

Aplicativos de modelo-less

Normally in py4web the code that define DAL tables lives in the file

models.py, hence it’s only executed at startup because it’s outside of actions.

However, it is possible to define DAL tables on demand inside actions. This is referred to as “model-less” development by the py4web community.

To use the “model-less” approach, you take responsibility for doing

all the housekeeping tasks. You call the table definitions when you

need them, and provide database connection passed as parameter.

Also, remember maintainability: other py4web developers expect to find

database definitions in the models.py file.

Bancos de dados replicados

The first argument of DAL(...) can be a list of URIs. In this case

py4web tries to connect to each of them. The main purpose for this is to

deal with multiple database servers and distribute the workload among

them. Here is a typical use case:

db = DAL(['mysql://...1', 'mysql://...2', 'mysql://...3'])

Neste case, as tentativas DAL para conectar-se a primeira e, em case de falha, ele vai tentar o segundo eo terceiro. Isto também pode ser utilizado para distribuir a carga em uma configuração de banco de dados mestre-escravo.

Palavras-chave reservadas

`` Check_reserved`` diz o construtor para verificar nomes de tabela e nomes de coluna contra palavras-chave reservada SQL em bancos de dados de back-end-alvo. `` padrões check_reserved`` a nenhum.

Esta é uma lista de strings que contêm os nomes de adaptador de banco de dados back-end.

The adapter name is the same as used in the DAL connection string. So if you want to check against PostgreSQL and MSSQL then your db connection would look as follows:

db = DAL('sqlite://storage.sqlite', check_reserved=['postgres', 'mssql'])

A DAL irá analisar as palavras-chave na mesma ordem da lista.

Existem duas opções extras “todos” e “comum”. Se você especificar tudo, ele irá verificar contra todas as palavras-chave SQL conhecidos. Se você especificar comum, ele só irá verificar contra palavras-chave SQL comuns, tais como `` SELECT``, `` INSERT``, `` update``, etc.

For supported back ends you may also specify if you would like to check

against the non-reserved SQL keywords as well. In this case you would

append _nonreserved to the name. For example:

check_reserved=['postgres', 'postgres_nonreserved']

Os seguintes backends de banco de dados suportar palavras reservadas verificação.

Database |

check_reserved |

|---|---|

** ** PostgreSQL |

`` Postgres (_nonreserved) `` |

** ** MySQL |

`` Mysql`` |

** ** FireBird |

`` Firebird (_nonreserved) `` |

** ** MSSQL |

`` mssql`` |

Oráculo |

`` oracle`` |

Configurações de quoting e case e do banco de dados

Citando de entidades SQL são ativadas por padrão em DAL, isto é:

`` Entity_quoting = True``

Desta forma, os identificadores são automaticamente citado em SQL gerado pelo DAL. No SQL palavras-chave de nível e identificadores não cotadas são maiúsculas e minúsculas, quoting assim uma SQL identificador torna maiúsculas de minúsculas.

Note-se que os identificadores não indicada deve sempre ser dobrado para minúsculas pelo motor de back-end acordo com a norma SQL, mas nem todos os motores estão em conformidade com o presente (por exemplo de dobragem PostgreSQL padrão é maiúsculas).

Por DAL padrão ignora case de campo também, para mudar este uso:

`` Ignore_field_case = False``

Para ter certeza de usar os mesmos nomes em python e no esquema DB, você deve organizar para ambas as configurações acima. Aqui está um exemplo:

db = DAL(ignore_field_case=False)

db.define_table('table1', Field('column'), Field('COLUMN'))

query = db.table1.COLUMN != db.table1.column

Fazendo uma conexão segura

Às vezes é necessário (e recomendado) para se conectar ao seu banco de dados usando conexão segura, especialmente se o seu banco de dados não está no mesmo servidor como a sua aplicação. Neste case, você precisa passar parâmetros adicionais para o driver de banco de dados. Você deve consultar a documentação do driver de banco de dados para obter detalhes.

Para PostgreSQL com psycopg2 ele deve ser parecido com isto:

DAL('postgres://user_name:user_password@server_addr/db_name',

driver_args={'sslmode': 'require', 'sslrootcert': 'root.crt',

'sslcert': 'postgresql.crt', 'sslkey': 'postgresql.key'})

onde os parâmetros `` sslrootcert``, `` sslcert`` e `` sslkey`` deve conter o caminho completo para os arquivos. Você deve consultar a documentação do PostgreSQL sobre como configurar o servidor PostgreSQL para aceitar conexões seguras.

Outros parâmetros do construtor DAL

Local de pasta do banco de dados

folder sets the place where migration files will be created (see

Migrations for details). By default it’s automatically set within py4web on the same

folder of the database itself, but you have to specify it when using DAL outside py4web.

Note that for SQLite databases it’s normally necessary, otherwise you’ll implicitly choose an in memory database (where folder and migrations don’t have any sense). So these constructors have the same meaning:

db = DAL('sqlite://storage.sqlite') # folder parameter not specified

db = DAL('sqlite:memory') # in memory database

Configurações padrão de migração

The DAL constructor migration settings are booleans affecting defaults and global behaviour (again, see Migrations for details)

`` Migrar = True`` define o comportamento de migração padrão para todas as tabelas

`` Fake_migrate = False`` define o comportamento fake_migrate padrão para todas as tabelas

`` Migrate_enabled = True`` se definido como desativa falsas todas as migrações

`` Fake_migrate_all = False`` Se definido como falso migra Verdadeiros todas as tabelas

`` `` commit`` e rollback``

The insert, truncate, delete, and update operations aren’t actually committed until py4web issues the commit command. The create and drop operations may be executed immediately, depending on the database engine.

If you pass db in an action.uses decorator, you don’t need to call

commit in the controller, it is automatically done for you (also, if you use

authenticated or unauthenticated decorator.)

Dica

always add db in an action.uses decorator (or use the

authenticated or unauthenticated decorator).

Otherwise you have to add db.commit() in every define_table and

in every table activities: insert(), update(), delete()

So in actions there is normally no need to ever call

commit or rollback explicitly in py4web unless you need more

granular control.

But if you executed commands via the shell, you are required to manually commit:

>>> db.commit()

Para verificar isso, vamos inserir um novo registro:

>>> db.person.insert(name="Bob")

2

and roll de volta, ou seja, ignorar todas as operações desde o último commit:

>>> db.rollback()

Se você agora inserir novamente, o contador voltará a ser definido para 2, desde a inserção anterior foi revertida.

>>> db.person.insert(name="Bob")

2

Code in models, views and controllers is enclosed in py4web code that looks like this (pseudo code):

try:

execute models, controller function and view

except:

rollback all connections

log the traceback

send a ticket to the visitor

else:

commit all connections

save cookies, sessions and return the page

Construtor Table

As tabelas são definidos na DAL via `` define_table``.

assinatura define_table

A assinatura para o método define_table é:

define_table(tablename, *fields, **kwargs)

Ele aceita um nome de tabela de preenchimento obrigatório e um número opcional de `` cases Field`` (mesmo nenhum). Você também pode passar um Table`` objeto (ou subclasse) `` em vez de um `` Field`` um, este clones e adiciona todos os campos (mas o “id”) com a tabela de definição. Outros argumentos de palavra-chave opcionais são: `` rname``, `` redefine``, `` common_filter``, `` fake_migrate``, `` fields``, `` format``, `` migrate``, `` on_define``, `` plural``, `` polymodel``, `` primarykey``, `` sequence_name``, `` singular``, `` table_class``, e `` trigger_name``, que são discutidos abaixo.

Por exemplo:

>>> db.define_table('person', Field('name'))

<Table person (id, name)>

Ele define, lojas e retorna um objeto `` Table`` chamado “pessoa” contendo um campo (coluna) “nome”. Este objeto também pode ser acessado via `` db.person``, assim você não precisa pegar o valor retornado pelo define_table.

`` Id``: Notas sobre a chave primária

Não declare um campo chamado “id”, porque um é criado por py4web de qualquer maneira. Cada tabela tem um campo chamado “id” por padrão. É um campo inteiro de auto-incremento (geralmente a partir de 1) utilizados para referência cruzada e para fazer cada registro original, assim que “id” é uma chave primária. (Nota: o contador id a partir de 1 é específico back-end Por exemplo, isto não se aplica ao Google App Engine NoSQL..)

Opcionalmente, você pode definir um campo de “type =” id”`` e py4web usará este campo como campo id auto-incremento. Isso não é recomendado, exceto quando acessar as tabelas de banco de dados legado que têm uma chave primária com um nome diferente. Com alguma limitação, você também pode usar diferentes chaves primárias usando o parâmetro ` primarykey``.

`` `` Plural`` e singular``

As pyDAL is a general DAL, it includes plural and singular attributes to refer to the table names so that external elements can use the proper name for a table.

`` Redefine``

As tabelas podem ser definidas apenas uma vez, mas você pode forçar py4web redefinir uma tabela existente:

db.define_table('person', Field('name'))

db.define_table('person', Field('name'), redefine=True)

A redefinição pode provocar uma migração se definição tabela muda.

`` Format``: representação da ficha

É opcional, mas recomendado para especificar uma representação formato para registros com o parâmetro `` format``.

db.define_table('person', Field('name'), format='%(name)s')

ou

db.define_table('person', Field('name'), format='%(name)s %(id)s')

ou mesmo os mais complexos usando uma função:

db.define_table('person', Field('name'),

format=lambda r: r.name or 'anonymous')

The format attribute will be used for two purposes:

To represent referenced records in select/option drop-downs.

To set the

db.othertable.otherfield.representattribute for all fields referencing this table. This means that theFormconstructor will not show references by id but will use the preferred format representation instead.

`` Rname``: nome real

rname sets a database backend name for the table. This makes the

py4web table name an alias, and rname is the real name used when

constructing the query for the backend. To illustrate just one use,

rname can be used to provide MSSQL fully qualified table names

accessing tables belonging to other databases on the server:

rname = 'db1.dbo.table1'

`` Primarykey``: Suporte para tabelas legadas

primarykey helps support legacy tables with existing primary keys,

even multi-part. See Legacy databases and keyed tables.

`` Migrate``, `` fake_migrate``

migrate sets migration options for the table. Refer to

Migrations for details.

`` Table_class``

If you define your own table class as a sub-class of pydal.objects.Table, you can provide it here; this allows you to extend and override methods. Example:

from pydal.objects import Table

class MyTable(Table):

...

db.define_table(..., table_class=MyTable)

`` Sequence_name``

O nome de uma seqüência tabela personalizada (se suportado pelo banco de dados). Pode criar uma seqüência (a partir de 1 e incrementando por 1) ou usar isso para tabelas legadas com seqüências personalizadas.

Observe que, quando necessário, py4web vai criar seqüências automaticamente por padrão.

`` Trigger_name``

Refere-se a `` sequence_name``. Relevante para alguns backends que não suportam campos numéricos auto-incremento.

`` polymodel``

For use with Google App Engine.

`` On_define``

`` On_define`` é uma chamada de retorno acionado quando um lazy_table é instanciado, embora ela é chamada de qualquer maneira, se a tabela não é preguiçoso. Isso permite que mudanças dinâmicas para a mesa sem perder as vantagens de instanciação adiada.

Exemplo:

db = DAL(lazy_tables=True)

db.define_table('person',

Field('name'),

Field('age', 'integer'),

on_define=lambda table: [

table.name.set_attributes(requires=IS_NOT_EMPTY(), default=''),

table.age.set_attributes(requires=IS_INT_IN_RANGE(0, 120), default=30) ])

Nota Este exemplo mostra como usar `` on_define`` mas não é realmente necessário. O simples `` valores requires`` poderiam ser adicionados às definições de campo ea mesa ainda seria preguiçoso. No entanto, `` requires`` que tomar um objeto definido como o primeiro argumento, como IS_IN_DB, vai fazer uma consulta como `` db.sometable.somefield == some_value`` que causaria `` sometable`` a ser definido no início . Esta é a situação salvos por `` on_define``.

Adicionando atributos para campos e tabelas

Se você precisa adicionar atributos personalizados aos campos, você pode simplesmente fazer isso: `` db.table.field.extra = {} ``

“extra” is not a keyword; it’s a custom attribute now attached to the field object. You can do it with tables too but they must be preceded by an underscore to avoid naming conflicts with fields:

db.table._extra = {}

Bancos de dados legados e tabelas com chave

py4web pode se conectar a bancos de dados legados sob algumas condições.

The easiest way is when these conditions are met:

Each table must have a unique auto-increment integer field called “id”.

Records must be referenced exclusively using the “id” field.

Ao acessar uma tabela existente, isto é, uma tabela não criado por py4web no aplicativo atual, sempre definir `` migrar = False``.

If the legacy table has an auto-increment integer field but it is not

called “id”, py4web can still access it but the table definition must

declare the auto-increment field with ‘id’ type (that is using

Field('...', 'id')).

Finalmente se a tabela de legado usa uma chave primária que não é um campo id auto-incremento é possível usar uma “mesa com chave”, por exemplo:

db.define_table('account',

Field('accnum', 'integer'),

Field('acctype'),

Field('accdesc'),

primarykey=['accnum', 'acctype'],

migrate=False)

`` Primarykey`` é uma lista dos nomes de campo que compõem a chave primária.

Todos os campos PrimaryKey tem um `` NÃO NULL`` definido, mesmo se não especificado.

Tabelas com chave só podem referenciar outras tabelas com chave.

Campos de referência devem usar o

reference tablename.fieldname.A `` função update_record`` não está disponível para filas de mesas com chave.

Atualmente tabelas chaveadas são suportadas apenas para DB2, MSSQL, Ingres e Informix, mas serão adicionados outros engines.

No momento da escrita, não podemos garantir que os `` obras de atributos primarykey`` com cada mesa legado existente e cada backend de banco de dados suportado. Para simplificar, recomendamos, se possível, criando uma visão do banco de dados que tem um campo id auto-incremento.

Construtor Field

Estes são os valores padrão de um construtor de campo:

Field(fieldname, type='string', length=None, default=DEFAULT,

required=False, requires=DEFAULT,

ondelete='CASCADE', notnull=False, unique=False,

uploadfield=True, widget=None, label=None, comment=None,

writable=True, readable=True, searchable=True, listable=True,

update=None, authorize=None, autodelete=False, represent=None,

uploadfolder=None, uploadseparate=None, uploadfs=None,

compute=None, filter_in=None, filter_out=None,

custom_qualifier=None, map_none=None, rname=None)

onde padrão é um valor especial usado para permitir que o valor Nenhum para um parâmetro.

Nem todos eles são relevantes para todos os campos. `` Length`` é relevante apenas para campos do tipo “string”. `` Uploadfield``, `` authorize``, e `` autodelete`` são relevantes apenas para campos do tipo “Upload”. `` Ondelete`` é relevante apenas para campos do tipo “referência” e “Upload”.

`` Length`` define o comprimento máximo de uma “string”, “password” ou campo “Upload”. Se `` length`` não for especificado um valor padrão é usado, mas o valor padrão não é garantido para ser compatível. * Para evitar migrações indesejadas em upgrades, recomendamos que você sempre especificar o comprimento de campos de cordas, senha e upload. *

`` Default`` define o valor padrão para o campo. O valor padrão é utilizada quando se realiza uma inserção se um valor não for especificado explicitamente. É também usado para formas construídas a partir da tabela usando `` Form``-preencher previamente. Note, em vez de ser um valor fixo, o padrão em vez disso pode ser uma função (incluindo uma função lambda) que retorna um valor do tipo apropriado para o campo. Nesse case, a função é chamada uma vez para cada registro inserido, mesmo quando vários registros são inseridos em uma única transação.

`` Required`` conta a DAL que nenhuma inserção deve ser permitido nesta tabela se um valor para este campo não é especificado explicitamente.

requiresis a validator or a list of validators. This is not used by the DAL, but instead it is used byForm(this will be explained better on the Forumlários chapter). The default validators for the given types are shown in the next section Field types and validators.Nota

while

requires=...is enforced at the level of forms,required=Trueis enforced at the level of the DAL (insert). In addition,notnull,uniqueandondeleteare enforced at the level of the database. While they sometimes may seem redundant, it is important to maintain the distinction when programming with the DAL.`` Rname`` fornece o campo com um “nome real”, um nome para o campo conhecido para o adaptador de banco de dados; quando o campo é usado, ele é o valor rname que é enviado para o banco de dados. O nome py4web para o campo é então efetivamente um alias.

`` Ondelete`` traduz na “ON DELETE” instrução SQL. Por padrão, ele é definido como “em cascata”. Isso diz ao banco de dados que quando se exclui um registro, ele também deve excluir todos os registros que se referem a ele. Para desativar este recurso, conjunto de `` ondelete`` a “nenhuma acção” ou “NULL SET”.

`` Notnull = True`` se traduz na “NOT NULL” instrução SQL. Ela impede que a banco de dados a partir da inserção de valores nulos para o campo.

`` Unique = True`` se traduz na instrução SQL “único” e ele garante que os valores deste campo são exclusivos dentro da tabela. Ela é aplicada no nível de banco de dados.

uploadfieldapplies only to fields of type “upload”. A field of type “upload” stores the name of a file saved somewhere else, by default on the filesystem under the application “uploads/” folder. Ifuploadfieldis set to True, then the file is stored in a blob field within the same table and the value ofuploadfieldis the name of the blob field. This will be discussed in more detail later in More on uploads.uploadfoldermust be set to a location where to store uploaded files. The scaffolding app defines a foldersettings.UPLOAD_FOLDERwhich points toapps/{app_name}/uploadsso you can set, for example,Field(... uploadfolder=settings.UPLOAD_FOLDER).uploadseparateif set to True will upload files under different subfolders of the uploadfolder folder. This is optimized to avoid too many files under the same folder/subfolder. ATTENTION: You cannot change the value ofuploadseparatefrom True to False without breaking links to existing uploads. pydal either uses the separate subfolders or it does not. Changing the behavior after files have been uploaded will prevent pydal from being able to retrieve those files. If this happens it is possible to move files and fix the problem but this is not described here.`` Uploadfs`` permite que você especificar um sistema de arquivos diferente, onde fazer o upload de arquivos, incluindo um armazenamento Amazon S3 ou um armazenamento de SFTP remoto.

Você precisa ter PyFileSystem instalado para que isso funcione. `` Uploadfs`` deve apontar para PyFileSystem.

autodeletedetermines if the corresponding uploaded file should be deleted when the record referencing the file is deleted. For “upload” fields only. However, records deleted by the database itself due to a CASCADE operation will not trigger py4web’s autodelete.labelis a string (or a helper or something that can be serialized to a string that contains the label to be used for this field in auto-generated forms.) that contains a comment associated with this field, and will be displayed to the right of the input field in the autogenerated forms.`` Writable`` declara se um campo é gravável em formulários.

`` Readable`` declara se um campo é legível em formulários. Se um campo não é nem legível, nem gravável, não será exibido em criar e atualizar formas.

`` Update`` contém o valor padrão para este campo quando o registro é atualizado.

`` Compute`` é uma função opcional. Se um registro é inserido ou atualizado, a função de computação será executado eo campo será preenchido com o resultado da função. O registro é passado para a função de computação como um `` dict``, eo dict não incluirá o valor atual de que, ou qualquer outro campo de computação.

`` Authorize`` pode ser usado para exigir o controle de acesso no campo correspondente, para apenas os campos “Upload”. Ele será discutido mais em detalhe no contexto de autenticação e autorização.

widgetDo NOT use the widget parameter in py4web for a Field definition. (This was a feature of web2py and is not to be used in py4web) See Widgets later.representcan be None or can point to a function that takes a field value and returns an alternate representation for the field value.

Thread safety and Field attributes

Even though py4web and web2py use the same pyDAL, there is an important difference

which stems from the core architecture of py4web.

In py4web only the following Field attributes can be changed inside an action:

readablewritabledefaultfilter_infilter_outlabelupdaterequireswidgetrepresent

These are reset to their original values before each action is called.

All other Field, DAL, and Table attributes are global and non-thread-safe.

This limitation exists because py4web executes table definitions only at startup, unlike web2py which re-defines tables on each request. This makes py4web a lot faster than web2py, but you need to be careful as modifying non-thread-safe attributes in actions can cause race conditions and bugs.

Field types and validators

Type |

Default validators |

|---|---|

`` String`` |

`` IS_LENGTH (comprimento) `` comprimento padrão é 512 |

`` text`` |

`` IS_LENGTH (comprimento) `` comprimento padrão é 32.768 |

`` blob`` |

`` Comprimento padrão None`` é 2 ** 31 (2 GIB) |

`` boolean`` |

`` None`` |

`` integer`` |

`` IS_INT_IN_RANGE (** -2 31, 2 ** 31) `` |

`` Double`` |

`` IS_FLOAT_IN_RANGE (-1e100, 1e100) `` |

`` Decimal (n, m) `` |

|

`` date`` |

`` IS_DATE () `` |

`` Time`` |

`` IS_TIME () `` |

`` datetime`` |

`` IS_DATETIME () `` |

`` password`` |

`` IS_LENGTH (comprimento) `` comprimento padrão é 512 |

`` Upload`` |

`` Comprimento padrão é 512 None`` |

`` Referência <table> `` |

`` IS_IN_DB (db, table.field, formato) `` |

`` Lista: string`` |

`` None`` |

`` Lista: integer`` |

`` None`` |

`` Lista: referência <table> `` |

|

`` json`` |

`` IS_EMPTY_OR (IS_JSON ()) `` comprimento padrão é 512 |

`` bigint`` |

`` IS_INT_IN_RANGE (** -2 63, 2 ** 63) `` |

`` Grande-id`` |

`` None`` |

`` Grande-reference`` |

`` None`` |

Decimal requer e devolve valores como `` objectos Decimal``, como definidos na Python `` decimal`` módulo. SQLite não lidar com o `` decimal`` tipo assim internamente que tratá-lo como um `` double``. O (n, m) são o número de dígitos no total e o número de dígitos após o ponto decimal, respectivamente.

A `` grande-id`` e, `` grande-reference`` são suportados apenas por alguns dos mecanismos de bases de dados e são experimentais. Eles não são normalmente usados como tipos de campo a menos de tabelas legadas, no entanto, o construtor DAL tem um argumento `` bigint_id`` que, quando definido para `` True`` faz com que os `` campos id`` e `` campos reference`` `` grande-id`` e `` grande-reference`` respectivamente.

The list:<type> fields are special because they are designed to take

advantage of certain denormalization features on NoSQL (in the case of

Google App Engine NoSQL, the field types ListProperty and

StringListProperty) and back-port them all the other supported

relational databases. On relational databases lists are stored as a

text field. The items are separated by a | and each | in

string item is escaped as a ||. They are discussed in

`` Lista: <type> `` e `` contains``.

The json field type is pretty much explanatory. It can store any

JSON serializable object. It is designed to work specifically for

MongoDB and backported to the other database adapters for portability.

blob fields are also special. By default, binary data is encoded in

base64 before being stored into the actual database field, and it is

decoded when extracted. This has the negative effect of using 33% more

storage space than necessary in blob fields, but has the advantage of

making the communication independent of the back-end specific escaping

conventions.

modificação da tabela e campo em tempo de execução

A maioria dos atributos de campos e tabelas podem ser modificados depois que eles são definidos:

>>> db.define_table('person', Field('name', default=''), format='%(name)s')

<Table person (id, name)>

>>> db.person._format = '%(name)s/%(id)s'

>>> db.person.name.default = 'anonymous'

aviso de que os atributos de tabelas são geralmente precedido por um sublinhado para evitar conflitos com possíveis nomes de campo.

Você pode listar as tabelas que foram definidos para uma determinada conexão com o banco:

>>> db.tables

['person']

Você pode consultar para o tipo de uma tabela:

>>> type(db.person)

<class 'pydal.objects.Table'>

Você pode acessar uma tabela utilizando diferentes sintaxes:

>>> db.person is db['person']

True

Você também pode listar os campos que foram definidos para uma determinada tabela:

>>> db.person.fields

['id', 'name']

Da mesma forma você pode acessar campos de seu nome de várias maneiras equivalentes:

>>> type(db.person.name)

<class 'pydal.objects.Field'>

>>> db.person.name is db.person['name']

True

Dado um campo, você pode acessar os atributos definidos em sua definição:

>>> db.person.name.type

string

>>> db.person.name.unique

False

>>> db.person.name.notnull

False

>>> db.person.name.length

32

incluindo a sua tabela pai, tablename, e ligação parent:

>>> db.person.name._table == db.person

True

>>> db.person.name._tablename == 'person'

True

>>> db.person.name._db == db

True

Um campo também tem métodos. Alguns deles são utilizados para consultas de construção e vamos vê-los mais tarde. Um método especial do objeto de campo é `` validate`` e chama os validadores para o campo.

>>> db.person.name.validate('John')

('John', None)

que retorna um tuplo `` (valor, erro) . `` `` Error é None`` se a entrada passa a validação.

Mais sobre envios

Considere o seguinte modelo:

db.define_table('myfile',

Field('image', 'upload', default='path/to/file'))

No case de um campo de “carregamento”, o valor padrão pode, opcionalmente, ser definida como um caminho (um caminho absoluto ou um caminho relativo para a pasta aplicativo atual), o valor padrão é então atribuído a cada novo registro que não especifica um imagem.

Observe que desta forma vários registros podem acabar com referência ao mesmo arquivo de imagem padrão e isso poderia ser um problema em um campo ter `` autodelete`` habilitado. Quando você não quer permitir duplicatas para o campo de imagem (ou seja, vários registros referenciando o mesmo arquivo), mas ainda quer definir um valor padrão para o “carregamento”, então você precisa de uma forma de copiar o arquivo padrão para cada novo registro que faz não especificar uma imagem. Isto pode ser obtido usando um arquivo-como objeto referenciando o arquivo padrão como o argumento `` default`` ao campo, ou mesmo com:

Field('image', 'upload', default=dict(data='<file_content>', filename='<file_name>'))

Normalmente uma inserção é feita automaticamente através de um `` Form`` mas ocasionalmente você já tem o arquivo no sistema de arquivos e quer enviá-lo por meio de programação. Isso pode ser feito da seguinte maneira:

with open(filename, 'rb') as stream:

db.myfile.insert(image=db.myfile.image.store(stream, filename))

Também é possível inserir um arquivo de uma forma mais simples e tem a chamada de método de inserção `` store`` automaticamente:

with open(filename, 'rb') as stream:

db.myfile.insert(image=stream)

Neste case, o nome do ficheiro é obtido a partir do objecto corrente, se disponível.

O método store` do objeto campo carregamento leva um fluxo de arquivo e um nome de arquivo. Ele usa o nome do arquivo para determinar a extensão (tipo) do arquivo, cria um novo nome temporário para o arquivo (de acordo com mecanismo de upload py4web) e carrega o conteúdo do arquivo neste novo arquivo temporário (sob os envios de pasta salvo indicação em contrário). Ele retorna o novo nome temp, que é então armazenada no campo `` image`` da tabela `` db.myfile``.

Note, se o arquivo deve ser armazenado em um campo blob associado ao invés do sistema de arquivos, o método store` não irá inserir o arquivo no campo blob (porque` store` é chamado antes da inserção), portanto, o arquivo deve ser explicitamente inserido no campo blob:

db.define_table('myfile',

Field('image', 'upload', uploadfield='image_file'),

Field('image_file', 'blob'))

with open(filename, 'rb') as stream:

db.myfile.insert(image=db.myfile.image.store(stream, filename),

image_file=stream.read())

O método retrieve` faz o oposto do` store`.

Quando os arquivos enviados são armazenados no sistema de arquivos (como no case de um `` Field ( “imagem” simples, “upload”) ``) o código:

row = db(db.myfile).select().first()

(filename, fullname) = db.myfile.image.retrieve(row.image, nameonly=True)

recupera o nome do arquivo original (filename) como visto pelo usuário em tempo de upload e o nome do arquivo armazenado (fullname, com caminho relativo para a pasta da aplicação). Embora, em geral, a chamada:

(filename, stream) = db.myfile.image.retrieve(row.image)

recupera o nome original do arquivo (filename) e um arquivo-como objeto pronto para dados de arquivo de acesso carregado (stream).

Observe que o fluxo retornado por `` retrieve`` é um objeto de arquivo real no case de que os arquivos enviados são armazenados no sistema de arquivos. Nesse case, lembre-se de fechar o arquivo quando você é feito, chamando `` stream.close () ``.

Aqui está um exemplo de uso seguro do `` retrieve``:

from contextlib import closing

import shutil

row = db(db.myfile).select().first()

(filename, stream) = db.myfile.image.retrieve(row.image)

with closing(stream) as src, closing(open(filename, 'wb')) as dest:

shutil.copyfileobj(src, dest)

Migrações

With our example table definition:

db.define_table('person')

define_table checks whether or not the corresponding table exists.

If it does not, it generates the SQL to create it and executes the SQL.

If the table does exist but differs from the one being defined, it

generates the SQL to alter the table and executes it. If a field has

changed type but not name, it will try to convert the data (If you do

not want this, you need to redefine the table twice, the first time,

letting py4web drop the field by removing it, and the second time adding

the newly defined field so that py4web can create it). If the table

exists and matches the current definition, it will leave it alone. In

all cases it will create the db.person object that represents the

table.

Referimo-nos a esse comportamento como uma “migração”. py4web registra todas as migrações e migração tentativas no arquivo “Sql.log”.

Nota

by default py4web uses the “app/databases” folder for the

log file and all other migration files it needs. You can change this

setting by changing the folder argument to DAL. To set a different

log file name, for example “migrate.log” you can do

db = DAL(..., adapter_args=dict(logfile='migrate.log'))

The first argument of define_table is always the table name. The

other unnamed arguments are the fields. The function also takes

an optional keyword argument called “migrate”:

db.define_table('person', ..., migrate='person.table')

O valor de migrar é o nome do arquivo onde as informações lojas py4web migração interna para esta tabela. Esses arquivos são muito importantes e nunca deve ser removido enquanto existirem as tabelas correspondentes. Nos cases em que uma tabela foi descartado eo arquivo correspondente ainda existem, ele pode ser removido manualmente. Por padrão, migre é definida como True. Este causas py4web para gerar o nome do arquivo a partir de um hash da string de conexão. Se migre é definida como falso, a migração não é realizada, e py4web assume que a tabela existe no armazenamento de dados e que contém (pelo menos) os campos listados no `` define_table``.

Não pode haver duas tabelas no mesmo aplicativo com o mesmo nome migrar.

A classe DAL também leva um argumento “migrar”, que determina o valor padrão de migrar para chamadas para `` define_table``. Por exemplo,

db = DAL('sqlite://storage.sqlite', migrate=False)

irá definir o valor padrão de migrar para Falso quando `` db.define_table`` é chamado sem um argumento migrar.

Nota

py4web only migrates new columns, removed columns, and

changes in column type (except in SQLite). py4web does not migrate

changes in attributes such as changes in the values of default,

unique, notnull, and ondelete.

As migrações podem ser desativado para todas as tabelas de uma só vez:

db = DAL(..., migrate_enabled=False)

This is the recommended behavior when two apps share the same database. Only one of the two apps should perform migrations, the other should disable them.

Fixação migrações quebrados

Há dois problemas comuns com as migrações e existem formas de recuperar a partir deles.

Um problema é específico com SQLite. SQLite não impor tipos de coluna e não pode soltar colunas. Isto significa que se você tiver uma coluna do tipo string e você removê-lo, não é realmente removido. Se você adicionar a coluna novamente com um tipo diferente (por exemplo, data e hora) você acaba com uma coluna de data e hora que contém strings (lixo para fins práticos). não py4web não reclamar sobre isso, porque ele não sabe o que está no banco de dados, até que ele tenta recuperar registros e falha.

Se py4web retorna um erro em alguma função de análise ao selecionar registros, muito provavelmente isso é devido a dados corrompidos em uma coluna por causa da questão acima.

A solução consiste em actualizar todos os registos da tabela e a actualização dos valores na coluna em questão com Nenhum.

O outro problema é mais genérico, mas típico com MySQL. O MySQL não permitem mais de um ALTER TABLE em uma transação. Isto significa que py4web deve quebrar transações complexas em partes menores (um ALTER TABLE na época) e cometem uma peça no momento. Por isso, é possível que parte de uma transação complexa fica comprometida e uma parte falhar, deixando py4web em um estado corrompido. Por que parte de uma transação falhar? Uma vez que, por exemplo, envolve a alteração de uma tabela de conversão e uma coluna de strings dentro de uma coluna de data e hora, tentativas py4web para converter os dados, mas os dados não podem ser convertidos. O que acontece com py4web? Ele fica confuso sobre o que exatamente é a estrutura da tabela realmente armazenados no banco de dados.

A solução consiste em permitir migrações falsos:

db.define_table(...., migrate=True, fake_migrate=True)

Isto irá reconstruir metadados py4web sobre a tabela de acordo com a definição da tabela. Tente várias definições de tabela para ver qual delas funciona (aquele antes da migração falhou ea uma após a migração falhou). Uma vez que remove sucesso do `` fake_migrate = True`` parâmetro.

Before attempting to fix migration problems it is prudent to make a copy of “yourapp/databases/*.table” files.

Migração problemas também pode ser fixada para todas as tabelas de uma só vez:

db = DAL(..., fake_migrate_all=True)

Isso também falhará se o modelo descreve tabelas que não existem no banco de dados, mas pode ajudar a estreitar o problema.

Migração resumo controle

A lógica dos vários argumentos de migração estão resumidos neste pseudo-código:

if DAL.migrate_enabled and table.migrate:

if DAL.fake_migrate_all or table.fake_migrate:

perform fake migration

else:

perform migration

Table methods

`` Insert``

Dada uma tabela, você pode inserir registros

>>> db.person.insert(name="Alex")

1

>>> db.person.insert(name="Bob")

2

Inserir retorna o valor único “id” de cada registro inserido.

Você pode truncar a tabela, ou seja, excluir todos os registros e reinicie o contador do id.

>>> db.person.truncate()

Agora, se você inserir um registro novo, o contador recomeça a 1 (isto é específico back-end e não se aplica ao Google NoSQL):

>>> db.person.insert(name="Alex")

1

Observe que você pode passar um parâmetro para `` truncate``, por exemplo, você pode dizer SQLite para reiniciar o contador id.

>>> db.person.truncate('RESTART IDENTITY CASCADE')

O argumento é em SQL puro e, portanto, específico do motor.

py4web também fornece um método bulk_insert

>>> db.person.bulk_insert([{'name': 'Alex'}, {'name': 'John'}, {'name': 'Tim'}])

[3, 4, 5]

É preciso uma lista de dicionários de campos a serem inseridas e executa várias inserções ao mesmo tempo. Ele retorna a lista de valores “id” dos registros inseridos. Nos bancos de dados relacionais suportadas não há nenhuma vantagem em usar esta função ao invés de looping e realizando inserções individuais, mas no Google App Engine NoSQL, há uma grande vantagem de velocidade.

`` Query``, `` Set``, `` Rows``

Vamos considerar novamente a tabela definida (e caiu) anteriormente e inserir três registros:

>>> db.define_table('person', Field('name'))

<Table person (id, name)>

>>> db.person.insert(name="Alex")

1

>>> db.person.insert(name="Bob")

2

>>> db.person.insert(name="Carl")

3

Você pode armazenar a tabela em uma variável. Por exemplo, com variável `` Person``, você poderia fazer:

>>> person = db.person

Você também pode armazenar um campo em uma variável como `` name``. Por exemplo, você também pode fazer:

>>> name = person.name

Você pode até criar uma consulta (usando operadores como ==, =, <,>, <=,> =, como, pertence!) E armazenar a consulta em uma variável `` q`` tal como em:

>>> q = name == 'Alex'

Quando você chamar `` db`` com uma consulta, você define um conjunto de registros. Você pode armazená-lo em uma variável `` s`` e escreve:

>>> s = db(q)

Observe que nenhuma consulta de banco de dados foi realizada até agora. DAL + consulta simplesmente definir um conjunto de registros neste db que correspondem a consulta. py4web determina a partir da consulta que tabela (ou tabelas) estão envolvidos e, de fato, não há necessidade de especificar isso.

`` Update_or_insert``

Algumas vezes você precisa executar uma inserção somente se não há nenhum registro com os mesmos valores como aqueles que estão sendo inseridos. Isso pode ser feito com

db.define_table('person',

Field('name'),

Field('birthplace'))

db.person.update_or_insert(name='John', birthplace='Chicago')

O registro será inserido somente se não houver nenhum outro usuário chamado John nascido em Chicago.

Você pode especificar quais valores usar como uma chave para determinar se existe o registro. Por exemplo:

db.person.update_or_insert(db.person.name == 'John',

name='John',

birthplace='Chicago')

e se houver John sua terra natal será atualizado então um novo registro será criado.

Os critérios de selecção no exemplo acima é um único campo. Ele também pode ser uma consulta, tais como

db.person.update_or_insert((db.person.name == 'John') & (db.person.birthplace == 'Chicago'),

name='John',

birthplace='Chicago',

pet='Rover')

`` Validate_and_insert``, `` validate_and_update``

A função

ret = db.mytable.validate_and_insert(field='value')

funciona muito bem como

id = db.mytable.insert(field='value')

except that it calls the validators for the fields before performing the

insert and bails out if the validation does not pass. If validation does

not pass the errors can be found in ret["errors"]. ret["errors"] holds

a key-value mapping where each key is the field name whose validation

failed, and the value of the key is the result from the validation error

(much like form["errors"]). If it passes, the id of the new record is

in ret["id"]. Mind that normally validation is done by the form

processing logic so this function is rarely needed.

Similarmente

ret = db(query).validate_and_update(field='value')

funciona muito da mesma forma como

num = db(query).update(field='value')

except that it calls the validators for the fields before performing the

update. Notice that it only works if query involves a single table. The

number of updated records can be found in ret["updated"] and errors

will be in ret["errors"].

`` Drop``

Finalmente, você pode soltar tabelas e todos os dados serão perdidos:

db.person.drop()

QueryBuilder

You can generate DAL queries using natural language. This can be done as follows:

from py4web import DAL, Field

from pydal import QueryBuilder, QueryParseError

db = DAL("sqlite:memory")

db.define_table("thing", Field("name"), Field("solid", "boolean"))

builder = QueryBuilder(db.thing)

query = builder.parse('name is equal to Chair')

rows = db(query).select()

Example of valid expressions are:

name is null

name is not null

name == Chair

name is Chair

name is equal Chair

name is equal to Chair

name is equal to «Chair»

name lower is equal to Chair

not name lower is equal to Chair

not (name lower is equal to Chair)

name == Chair or name == Table

name starts with C and name contains air

name in Chair, Table, Glass

name belongs Chair, Table, «Glass Top»

solid is true

solid is false

Notice that quotes are optional and only for values. You can use brakets to group. It throws a QueryParseError exception on failure. You can pass optional parameters to QueryBuilder for internationalization purposes (Italian in example):

builder = QueryBuilder(db.thing,

field_aliases={"id": "id", "nome": "name"},

token_aliases={"non è nullo": "is not null", "è uguale a": "=="})

query = builder.parse('nome non è nullo')

query = builder.parse('nome è uguale a Tavolo')

If field_aliases is not provided, only readable fields can be searched. If field_aliases is provided, only explicitedly included field names can be searched.

You can, of course, use the translation operator T:

builder = QueryBuilder(db.thing,

field_aliases={str(T(field.name)): field name for field in db.thing},

token_aliases={str(T(key):key) for key in QueryBuilder.token_ops})

You can alias the following tokens:

{

# boolean tokens

"not",

"and",

"or",

# field transformers

"upper",

"lower",

# unary search expressions

"is null",

"is not null",

"is true",

"is false",

# binary search expressions

"==",

"!=",

"<",

">",

"<=",

">=",

"contains",

"startswith", # notice "starts with" is an alias!

# search in list

"belongs",

}

The query builder is used in the Grid. In the Grid the field aliases are the field.label in lower case with the spaces replaced by underscore.

Marcação de registros

Etiquetas permite adicionar ou encontrar propriedades anexadas aos registros em seu banco de dados.

from py4web import DAL, Field

from pydal.tools.tags import Tags

db = DAL("sqlite:memory")

db.define_table("thing", Field("name"))

id1 = db.thing.insert(name="chair")

id2 = db.thing.insert(name="table")

properties = Tags(db.thing)

properties.add(id1, "color/red")

properties.add(id1, "style/modern")

properties.add(id2, "color/green")

properties.add(id2, "material/wood")

assert properties.get(id1) == ["color/red", "style/modern"]

assert properties.get(id2) == ["color/green", "material/wood"]

rows = db(properties.find(["style/modern"])).select()

assert rows.first().id == id1

rows = db(properties.find(["material/wood"])).select()

assert rows.first().id == id2

rows = db(properties.find(["color"])).select()

assert len(rows) == 2

Tags are hierarchical. Then find([“color”]) would return id1 and id2

because both records have tags with “color”.

It is internally implemented with the creation of an additional table, which in

this example would be db.thing_tags_default, because no tail was

specified on the Tags(table, tail=“default”) constructor.

py4web uses Tags as a flexible mechanism to manage permissions, we’ll see

all the details later on the Authorization using Tags chapter.

Raw SQL

`` executesql``

A DAL permite emitir explicitamente instruções SQL.

>>> db.executesql('SELECT * FROM person;')

[(1, u'Massimo'), (2, u'Massimo')]

Neste case, os valores de retorno não são analisados ou transformados pela DAL, eo formato depende do driver de banco de dados específico. Este uso com selecciona normalmente não é necessário, mas é mais comum com índices.

`` Executesql`` leva cinco argumentos opcionais: `` placeholders``, `` as_dict``, `` fields``, `` colnames``, e `` as_ordered_dict``.

`` Placeholders`` é uma seqüência opcional de valores a serem substituídos ou, se suportado pelo driver DB, um dicionário com chaves correspondentes chamado espaços reservados no seu SQL.

If as_dict is set to True, the results cursor returned by the DB

driver will be converted to a sequence of dictionaries keyed with the db

field names. Results returned with as_dict = True are the same as

those returned when applying as_list() to a normal select:

[{'field1': val1_row1, 'field2': val2_row1}, {'field1': val1_row2, 'field2': val2_row2}]

`` As_ordered_dict`` é muito bonito como `` as_dict`` mas os antigos garante que a ordem dos resultando campos (teclas OrderedDict) refletem a ordem em que eles são retornados de DB motorista:

[OrderedDict([('field1', val1_row1), ('field2', val2_row1)]),

OrderedDict([('field1', val1_row2), ('field2', val2_row2)])]

O argumento `` fields`` é uma lista de objetos DAL de campo que correspondem aos campos retornados da DB. Os objectos de campo devem ser parte de um ou mais objectos Tabela definido no objecto DAL. A `` lista fields`` pode incluir um ou mais DAL Tabela objetos em adição a ou em vez de incluir Campo objetos, ou pode ser apenas uma única tabela (não de uma lista). Nesse case, os objectos de campo vai ser extraído da tabela (s).

Em vez de especificar o argumento `` fields``, o argumento `` colnames`` pode ser especificado como uma lista de nomes de campos em formato tabela.campo. Novamente, estes devem representar tabelas e campos definidos no objeto DAL.

Também é possível especificar `` fields`` eo associado `` colnames``. Nesse case, `` fields`` pode também incluir objetos Expressão DAL, além de objetos de campo. Para objetos de campo em “campos”, o associado `` colnames`` ainda deve estar no formato tabela.campo. Para Expression objetos em `` fields``, o associado `` colnames`` podem ser quaisquer rótulos arbitrários.

Observe, a Tabela DAL objectos referidos por `` fields`` ou `` colnames`` pode ser fictícios mesas e não têm para representar todas as tabelas reais no banco de dados. Além disso, nota que o `` fields`` e `` colnames`` devem estar na mesma ordem que os campos nos resultados cursor retornado do DB.

`` _Lastsql``

Se SQL foi executado manualmente usando ExecuteSQL ou foi SQL gerado pelo DAL, você sempre pode encontrar o código SQL em `` db._lastsql``. Isso é útil para fins de depuração:

>>> rows = db().select(db.person.ALL)

>>> db._lastsql

SELECT person.id, person.name FROM person;

py4web never generates queries using the “*” operator. py4web is always explicit when selecting fields.

Temporização de consultas

All queries are automatically timed by py4web. The variable

db._timings is a list of tuples. Each tuple contains the raw SQL

query as passed to the database driver and the time it took to execute

in seconds.

Índices

Atualmente, a API DAL não fornece um comando para criar índices em tabelas, mas isso pode ser feito usando o comando `` executesql``. Isso ocorre porque a existência de índices pode fazer migrações complexa, e é melhor para lidar com eles de forma explícita. Os índices podem ser necessários para esses campos que são usados em consultas recorrentes.

Aqui está um exemplo de como:

db = DAL('sqlite://storage.sqlite')

db.define_table('person', Field('name'))

db.executesql('CREATE INDEX IF NOT EXISTS myidx ON person (name);')

Outros dialetos banco de dados têm sintaxes muito semelhantes, mas pode não suportar o opcional “SE NÃO EXISTE” directiva.

Generating raw SQL

Às vezes você precisa para gerar o SQL, mas não executá-lo. Isso é fácil de fazer com py4web uma vez que cada comando que executa banco de dados IO tem um comando equivalente que não, e simplesmente retorna o SQL que teriam sido executados. Estes comandos têm os mesmos nomes e sintaxe como os funcionais, mas eles começam com um sublinhado:

Aqui é `` _insert``

>>> print(db.person._insert(name='Alex'))

INSERT INTO "person"("name") VALUES ('Alex');

Aqui é `` _count``

>>> print(db(db.person.name == 'Alex')._count())

SELECT COUNT(*) FROM "person" WHERE ("person"."name" = 'Alex');

Aqui é `` _select``

>>> print(db(db.person.name == 'Alex')._select())

SELECT "person"."id", "person"."name" FROM "person" WHERE ("person"."name" = 'Alex');

Aqui é `` _delete``

>>> print(db(db.person.name == 'Alex')._delete())

DELETE FROM "person" WHERE ("person"."name" = 'Alex');

E, finalmente, aqui é `` _update``

>>> print(db(db.person.name == 'Alex')._update(name='Susan'))

UPDATE "person" SET "name"='Susan' WHERE ("person"."name" = 'Alex');

Além disso, você sempre pode usar `` db._lastsql`` para retornar o código SQL mais recente, se foi executada manualmente usando ExecuteSQL ou foi SQL gerado pelo DAL.

`` Comando SELECT``

Dado um conjunto, `` s``, você pode buscar os registros com o comando `` SELECT``:

>>> rows = s.select()

It returns an iterable object of class pydal.objects.Rows whose

elements are Row objects. pydal.objects.Row objects act like

dictionaries, but their elements can also be accessed as attributes.

The former differ from the latter because

its values are read-only.

O objecto Fileiras permite loop sobre o resultado do seleccionar e imprimindo os valores dos campos seleccionados para cada linha:

>>> for row in rows:

... print(row.id, row.name)

...

1 Alex

Você pode fazer todas as etapas em uma declaração:

>>> for row in db(db.person.name == 'Alex').select():

... print(row.name)

...

Alex

O comando select pode tomar argumentos. Todos os argumentos sem nome são interpretados como os nomes dos campos que você deseja buscar. Por exemplo, você pode ser explícita no campo “id” e no campo “nome” buscar:

>>> for row in db().select(db.person.id, db.person.name):

... print(row.name)

...

Alex

Bob

Carl

O atributo mesa ALL permite especificar todos os campos:

>>> for row in db().select(db.person.ALL):

... print(row.id, row.name)

...

1 Alex

2 Bob

3 Carl

Observe que não há nenhuma strings de consulta passada para db. py4web entende que se você quiser todos os campos da pessoa mesa sem informações adicionais, então você quer todos os registros da pessoa mesa.

Uma sintaxe alternativa equivalente é o seguinte:

>>> for row in db(db.person).select():

... print(row.id, row.name)

...

1 Alex

2 Bob

3 Carl

e py4web entende que se você perguntar para todos os registros da pessoa mesa sem informações adicionais, então você quer todos os campos da tabela pessoa.

Dada uma linha

>>> row = rows[0]

você pode extrair seus valores usando várias expressões equivalentes:

>>> row.name

Alex

>>> row['name']

Alex

>>> row('person.name')

Alex

The latter syntax is particularly handy when selecting an expression instead of a column. We will show this later.

Você também pode fazer

rows.compact = False

desativar a notação

rows[i].name

e permitir que, em vez disso, a notação menos compacto:

rows[i].person.name

Sim isso é incomum e raramente necessário.

Row objetos também tem dois métodos importantes:

row.delete_record()

e

row.update_record(name="new value")

Usando um seleto para uso de memória inferior à base de iterador

Python “iterators” são um tipo de “preguiçoso-avaliação”. Eles dados ‘alimentar’ um passo de tempo; laços tradicionais Python criar todo o conjunto de dados na memória antes de looping.

O uso tradicional de selecionar é:

for row in db(db.table).select():

...

mas para um grande número de linhas, usando uma alternativa à base de iterador tem uso de memória dramaticamente inferior:

for row in db(db.table).iterselect():

...

Testes mostram que isto é de cerca de 10% mais rápido, mesmo em máquinas com muita RAM.

Renderizando Rows com represent

Você pode querer reescrever linhas retornadas por seleção para tirar proveito de informações de formatação contida na representa a criação dos campos.

rows = db(query).select()

repr_row = rows.render(0)

Se você não especificar um índice, você tem um gerador para iterar sobre todas as linhas:

for row in rows.render():

print(row.myfield)

Também pode ser aplicada a fatias:

for row in rows[0:10].render():

print(row.myfield)

Se você só quer transformar campos selecionados através do seu atributo “representar”, você pode incluí-los no argumento “campos”:

repr_row = row.render(0, fields=[db.mytable.myfield])

Note, it returns a transformed copy of the original Row, so there’s no update_record (which you wouldn’t want anyway) or delete_record.

Atalhos

A DAL suporta vários atalhos-simplificando código. Em particular:

myrecord = db.mytable[id]

retorna o registro com o dado `` id`` se ele existir. Se o `` id`` não existe, ele retorna `` None``. A declaração acima é equivalente a

myrecord = db(db.mytable.id == id).select().first()

Você pode excluir registros por id:

del db.mytable[id]

e isto é equivalente a

db(db.mytable.id == id).delete()

e exclui o registro com o dado `` id``, se ele existir.

Nota: esta sintaxe de atalho de exclusão actualmente não trabalha se * versionamento * é ativado

Você pode inserir registros:

db.mytable[None] = dict(myfield='somevalue')

É equivalente a

db.mytable.insert(myfield='somevalue')

e cria um novo registro com valores de campos especificados pelo dicionário sobre o lado direito.

Note: insert shortcut was previously db.table[0] = .... It has

changed in pyDAL 19.02 to permit normal usage of id 0.

Você pode atualizar os registros:

db.mytable[id] = dict(myfield='somevalue')

o qual é equivalente a

db(db.mytable.id == id).update(myfield='somevalue')

e atualiza um registro existente com os valores dos campos especificados pelo dicionário sobre o lado direito.

A obtenção de um `` row``

No entanto, outra sintaxe conveniente é o seguinte:

record = db.mytable(id)

record = db.mytable(db.mytable.id == id)

record = db.mytable(id, myfield='somevalue')

Aparentemente semelhante a `` db.mytable [id] `` a sintaxe acima é mais flexível e mais seguro. Antes de tudo, verifica se `` id`` é um int (ou `` str (id) `` é um int) e retorna `` None`` se não (nunca levanta uma exceção). Ele também permite especificar várias condições que o registro deve atender. Se eles não forem atendidas, ele também retorna `` None``.

Recursivas `` s SELECT``

Considere a pessoa tabela anterior e uma nova tabela “coisa” fazendo referência a uma “pessoa”:

db.define_table('thing',

Field('name'),

Field('owner_id', 'reference person'))

e um simples selecionar a partir desta tabela:

things = db(db.thing).select()

o qual é equivalente a

things = db(db.thing._id != None).select()

onde `` _id`` é uma referência para a chave principal da tabela. Normalmente `` db.thing._id`` é o mesmo que `` db.thing.id`` e vamos supor que na maior parte deste livro.

Para cada linha de coisas é possível buscar não apenas campos da tabela selecionada (coisa), mas também a partir de tabelas vinculadas (de forma recursiva):

for thing in things:

print(thing.name, thing.owner_id.name)

Aqui `` thing.owner_id.name`` requer um banco de dados escolha para cada coisa em coisas e por isso é ineficiente. Sugerimos usando junta sempre que possível, em vez de seleciona recursiva, no entanto, este é conveniente e prático ao acessar registros individuais.

Você também pode fazê-lo para trás, escolhendo os coisas referenciados por uma pessoa:

person = db.person(id)

for thing in person.thing.select(orderby=db.thing.name):

print(person.name, 'owns', thing.name)

Nesta última expressão `` person.thing`` é um atalho para

db(db.thing.owner_id == person.id)

isto é, o conjunto de thing`` `` s referenciados pelos actuais `` Person``. Esta sintaxe se decompõe se a tabela referenciando tem várias referências à tabela referenciada. Neste case é preciso ser mais explícito e usar uma consulta completa.

`` Orderby``, `` groupby``, `` limitby``, `` distinct``, `` having``, `` orderby_on_limitby``, `` join``, `` left``, `` cache``

O comando `` SELECT`` leva uma série de argumentos opcionais.

ordenar por

Você pode buscar os registros classificados pelo nome:

>>> for row in db().select(db.person.ALL, orderby=db.person.name):

... print(row.name)

...

Alex

Bob

Carl

Você pode buscar os registros classificados pelo nome em ordem inversa (aviso o til):

>>> for row in db().select(db.person.ALL, orderby=~db.person.name):

... print(row.name)

...

Carl

Bob

Alex

Você pode ter os registros obtida aparecem em ordem aleatória:

>>> for row in db().select(db.person.ALL, orderby='<random>'):

... print(row.name)

...

Carl

Alex

Bob

O uso de `` orderby = “<random>” `` não é suportada no Google NoSQL. No entanto, para superar esse limite, a classificação pode ser feito em linhas selecionadas:

import random

rows = db(...).select().sort(lambda row: random.random())

Você pode classificar os registros de acordo com vários campos concatenando-los com um “|”:

>>> for row in db().select(db.person.name, orderby=db.person.name|db.person.id):

... print(row.name)

...

Alex

Bob

Carl

groupby, tendo

Usando `` groupby`` juntamente com `` orderby``, você pode agrupar registros com o mesmo valor para o campo especificado (isto é back-end específico, e não é sobre o Google NoSQL):

>>> for row in db().select(db.person.ALL,

... orderby=db.person.name,

... groupby=db.person.name):

... print(row.name)

...

Alex

Bob

Carl

Pode usar `` having`` em conjunto com `` groupby`` ao grupo condicionalmente (apenas aqueles `` having`` a condição estão agrupados).

db(query1).select(db.person.ALL, groupby=db.person.name, having=query2)

Observe que os registros filtros Consulta1 a ser exibido, registros filtros Query2 ser agrupados.

distinto

Com o argumento `` distinta = True``, você pode especificar que você só quer selecionar registros distintos. Isto tem o mesmo efeito que o agrupamento usando todos os campos especificados, exceto que ele não necessita de classificação. Ao usar distinta é importante não para selecionar todos os campos, e em particular para não selecionar o campo “id”, senão todos os registros serão sempre distintas.

Aqui está um exemplo:

>>> for row in db().select(db.person.name, distinct=True):

... print(row.name)

...

Alex

Bob

Carl

Note que `` distinct`` também pode ser uma expressão, por exemplo:

>>> for row in db().select(db.person.name, distinct=db.person.name):

... print(row.name)

...

Alex

Bob

Carl

limitby

Com `` limitby = (min, max) ``, pode seleccionar um subconjunto dos registos de deslocamento = min, mas não incluindo offset = máx. No próximo exemplo nós selecionamos os dois primeiros registros a partir de zero:

>>> for row in db().select(db.person.ALL, limitby=(0, 2)):

... print(row.name)

...

Alex

Bob

orderby_on_limitby

Note-se que os padrões DAL de adicionar implicitamente um orderby ao usar um limitby. Isso garante a mesma consulta retorna os mesmos resultados de cada vez, importante para a paginação. Mas pode causar problemas de desempenho. use `` orderby_on_limitby = False`` para mudar isso (isso o padrão é True).

juntar-se, deixou

These are involved in managing One to many relation. They are described in Inner join and Left outer join sections respectively.

cache, em cache

An example use which gives much faster selects is:

rows = db(query).select(cache=(cache.get, 3600), cacheable=True)

Look at Caching selects, to understand what the trade-offs are.

Operadores lógicos

As consultas podem ser combinados usando o binário operador AND “` & `”:

>>> rows = db((db.person.name=='Alex') & (db.person.id > 3)).select()

>>> for row in rows: print row.id, row.name

>>> len(rows)

0

eo binário operador OR “` | `”: